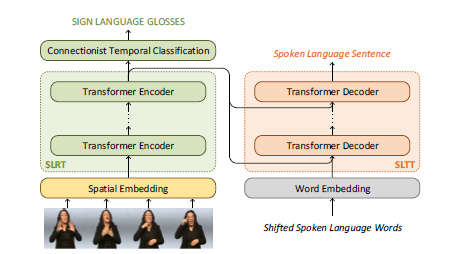

Sign Language Transformers: Joint End-to-end Sign Language Recognition and Translation 수어 번역 KCI를 위해 진행할 연구에서 Baseline으로 사용할 예정인 모델. Sign Language Transformer Abstract gloss 표현을 잘 사용하는 것이 번역 성능을 향상시킨다는 연구에 기반. end-to-end train이 가능하며 CTC손실을 통해 인식(SLR)과 번역(SLT) 문제를 단일 통합 아키텍쳐로 묶음. GT의 수화 동작의 시작 및 끝 타이밍에 대한 정보가 없이도 인식, 번역을 동시에 해결할 수 있어 더 효율적인 학습이 가능함. 이런 공동 접근 방식은 PHOENIX2014T 데이터셋에 대해 21.8의 BLEU4 ..